Poziom niezawodności początkowej (technicznej) każdego elementu jest modelowany głownie w sferze projektowania za pomocą zbioru cech związanych z dokładnością wymiarowo – kształtową Dwk, materiałem Wm, stanem warstwy wierzchniej ( W W ) Sww oraz podzbiorem cech modelowanych w montażu Me. Zbiór ten powinien być ustalony w ten sposób, żeby , ukształtowany poziom niezawodności początkowej zagwarantował następnie określony przebieg funkcji niezawodności elementu w czasie jego istnienia i (życia).

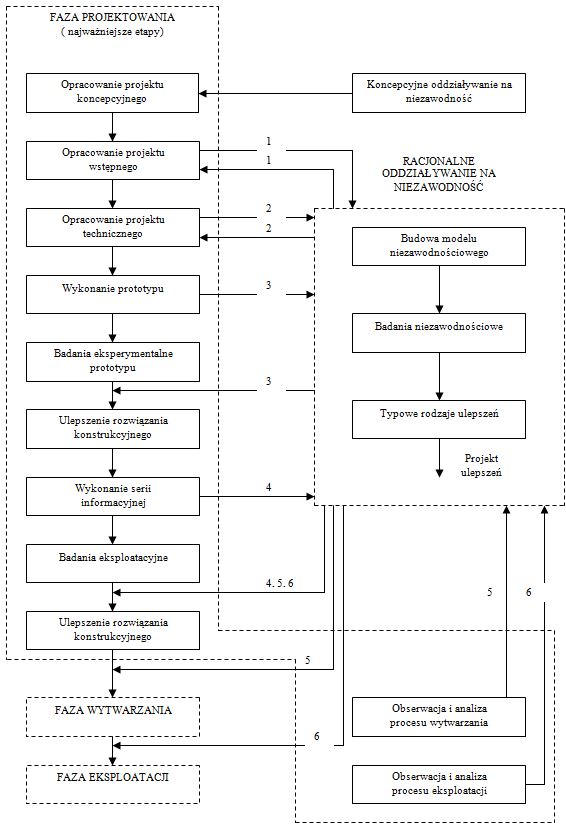

Funkcja niezawodności powinna być kształtowana w zakładowej czy też branżowej strukturze systemu jakości określonego ogólnie grupą norm ISO 9000 [7, 14] obejmującym wszystkie istotne etapy związane z powstawaniem i istnieniem elementu, co można przedstawić pętlą jakości (rys. 7). Pomimo że wymienione normy traktują niezawodność jako jedną z cech jakości, to jednak należy pamiętać, iż cecha ta decydująco stanowi o bezpieczeństwie obiektów mechanicznych, ich kosztach eksploatacji oraz jest w dalszym ciągu głównym przekonującym argumentem w ekspansji na światowym rynku.

O ważności właściwego kształtowania niezawodności elementów maszyn w aspekcie ich jakości świadczą najlepiej opracowane metody prognozowania trwałości elementów z wykorzystaniem techniki komputerowej [24], wspomagające projektowanie obiektów. W podobnym zamiarze czynione są przedsięwzięcia w sferze wytwarzania, szczególnie w zakresie doboru wariantów i struktury procesy, warunków obróbki, kontroli procesu [1, 2] nawet monitorowania tzw. „procesów specjalnych „.

Uwzględnianie dużej liczby aspektów ekonomicznych i fizycznych w badaniach, w ujęciu systemowym, wymaga przede wszystkim opisywanie obszaru zdatności Wz

w formie zwartej, a jednocześnie przejrzystej, wygodnej do zaprogramowania komputerowego [27]. Uwarunkowania te powinny ułatwić bieżącą weryfikację właściwości poszczególnych cech przy sterowaniu niezawodnością R(0) elementów. Biorąc to pod uwagę autor proponuje opisanie obszaru Wz za pomocą macierzy [2, 27]

AWz = [a]ij (101)

gdzie : i – liczba kolumn macierzy zawierająca cechy,

j – liczba wierszy macierzy zawierająca obszary zdatności podzbiorów

cech Dwk, Wm, Sww, Me.

W oparciu o dotychczasowy stan wiedzy i własne doświadczenia z zakresu omawianego zagadnienia [2] autor przedstawia propozycję opisania obszaru zdatności w odniesieniu szczególnie do elementów stanowiących tzw. „słabe ogniwa” w strukturze niezawodnościowej systemu technicznego.

Podzbiór cech wymiarowo-kształtowych (konstrukcyjnych) Dwk powinien zawierać następujące cechy o właściwościach granicznych:

– wymiary liniowe wielkości i kształtu ( Bai, Aai ), ( i = 1,…, n ),

– wymiary kątowe wielkości i kształtu ( Baj, Aaj ), ( j = 1,…, m ),

- wymiary liniowe charakteryzujące wzajemne położenie powierzchni elementu

( Bapk, Aapk), ( k = 1,…, K )

- wymiary kątowe charakteryzujące wzajemne położenie powierzchni elementu

( Bapl, Aapl), ( l = 1,…, L )

– cechy (opisowe) charakteryzujące sposób łączenia sąsiednich powierzchni (tzw. powierzchnie przejściowe) ( Codr, Corg ), ( r = 1,…, R ),

- dodatkowe cechy (opisowe) związane ze specyfiką rozpatrywanego elementu

(Csdv, Csyg ), ( v = 1,…, V ).

Właściwości graniczne tych cech wyznaczają podobszar zdatności elementu Wwk Ì Wz obrazowany za pomocą tolerancji, który może być przedstawiony wektorem:

Wwk = [ Tai, Taj, Tapk, Tapl, TCor, TCsv ] (83)

lub też macierzą właściwości granicznych cech:

(84)

Drugim ważnym podzbiorem jest podzbiór charakteryzujący właściwości materiału (tworzywa) elementu Wm na który składają się [2]:

– struktura materiału (mikrostruktura) S,

– parametry mechaniczne M,

– cechy uzupełniające X stanowiące parametry fizyczno-chemiczne, nie

uwzględnione w dwóch poprzednich grupach. W szczególności będą to cechy obejmujące:

– rodzaj fazy CFi, ( i = l,…, n ),

– objętość względną fazy ( CFvd, CFvg ),

– rozmieszczenie faz ( CFRd, CFRg ),

– rozmieszczenie składników faz ( CFsd, CFsg ),

– rozmiar ziarna ( Czd, Czg ),

– rozmieszczenie ziaren ( Czrd, Czrg),

– granice krawędzi ziaren ( Czkd, Czkg )

– teksturę ziaren (strefę ukierunkowania) ( CTzd, CTzg ),

– teksturę krystaliczną ( CTkd, CTkg ),

– rodzaj defektów struktury ( Cdj, ( j = 1,…, m )),

– gęstość defektów struktury ( Cdgd, Cdgg ),

– okresowość struktury ( Cfsd, Cfsg ),

– twardość ( HM(d), HMg ),

– granicę plastyczności ( Re(d), Reg ),

– wytrzymałość na rozciąganie ( Rm(d), Rmg ),

– udarność ( Ud, Ug ),

– moduł Younga ( Ed, Eg ),

– naprężenie własne (makronaprężenia) ( sM(d), sMg ),

– wytrzymałość na pełzanie ( RzT/t(d), RzT/tg ),

– granicę pełzania ( Rx/T/t(d), Rx/T/tg ),

– cechy uzupełniające ( XMld, XMlg ), ( l = 1,…, L ),

Podobszar zdatności łopatki Wm Ì Wz warunkowany podzbiorem Wm wyznacza następujący wektor:

Wm = [ TCFi, TCFv, TCFR, TCFs, TCz, TCzr, TCzk, TCTz, TCTk, TCDj, TCdg, TCfs, THM, TRe, TRm, TU, TE, TsM, TRz/T/t, TRx/T/t, TXML ] (85)

lub macierz wartości granicznych cech:

(86)

Z kolei podzbiór cech określających stan i właściwości użytkowe WW elementu obejmuje [2]:

– charakterystykę struktury geometrycznej powierzchni SGww,

– charakterystykę struktury fizyczno-chemicznej stref WW SFww. Zalecane podzbiory cech charakterystyki struktury geometrycznej powierzchni ujęte są w licznych normach krajowych i zagranicznych, jak np. PN-74/M-04255, PN-87/M-04251 oraz PN-87/M-04256/01 i 02. Propozycję z tego zakresu przedstawiono również w [1, 2]. Biorąc pod uwagę całokształt wymagań niezawodnościowych rozważanych elementów, w ich charakterystyce struktury geometrycznej proponuje się uwzględnienie:

– wysokości falistości powierzchni ( Wz(d), Wzg ),

– średniego odstępu falistości ( Sw(d), Swg ),

– największej wysokości falistości ( Wmax(d), Wmaxg ),

– średniego arytmetycznego odchylenia profilu ( Ra(d), Rag ),

– wysokości chropowatości według 10 punktów ( Rz(d), Rzg ),

– maksymalnej wysokości chropowatości ( Rmax(d), Rmaxg ),

– średniego odstępu chropowatości ( Sm(d), Smg ),

– średniego odstępu miejscowych wzniesień

profilu chropowatości ( Sd, Sg ),

– kierunkowości struktury powierzchni (ChTd, ChTg ),

– wskaźnika anizotropii (ad, ag ),

– parametru stereometrii powierzchni ( ChVd, ChVg ),

– wady struktury geometrycznej powierzchni ( PAd, PAg ),

Podzbiór ten tworzy podobszar zdatności WSG Ì Www który można przedstawić wektorem:

WSG = [ TWz, TSw, TWmax, TRa, TRz, TRmax, TSm, TS, TChT, Ta, TChV, TPA ]

(87)

lub macierzą właściwości granicznych cech:

(88)

Podzbiór cech charakteryzujących strukturę fizyczno-chemiczną stref WW, zgodnie z PN-87/M-04250 i zaleceniami podanymi w [2], powinien zawierać:

– rodzaj fazy WFi, ( i = 1,…, n ),

– objętość względną fazy ( WFvd, WFvg ),

– rozmieszczenie faz ( WFRd, WFRg ),

– rozmieszczenie składników faz ( WFsd, WFsg ),

– wymiar ziarna ( Wzd, Wzg ),

– rozmieszczenie ziarn ( Wzrd, Wzrg ),

– granice krawędzi ziarn ( Wzkd, Wzkg ),

– teksturę ziarn (strefę ukierunkowania) ( WTzd, WTzg ),

– teksturę krystaliczną ( WTkd, WTkg ),

– rodzaj defektów struktury Wdj, ( j = 1,…, m ),

– gęstość defektów struktury ( Wdgd, Wdgg ),

– okresowość struktury ( Wfsd, Wfsg ),

– twardość ( Hw(d), Hwg ),

– mikrotwardość ( Hmk(d), Hmkg ),

– mezotwardość ( Hmz(d), Hmzg ),

– naprężenia własne ( sw(d), swg ),

– cechy uzupełniające ( Xwl(d), Xwlg ), ( l = 1,…, ł )

Wektor podobszaru zdatności WSF Ì Www przyjmuje postać:

WSF = [TWFi, TWFv, TWFR, TWFs, TWz, TWzr, Twzk, TWTz, TWTk, TWdj, TWdg, TWfs, THw, THmk, THmz, Tsw, TXwl, ], (89)

a macierz:

(90)

Do podzbioru właściwości użytkowych ww można zaliczyć:

– wytrzymałość statyczną elementu ( ss(d), ssg ),

– wytrzymałość zmęczeniową elementu ( Zd, Zg ),

– odporność na zużycie korozyjne ( Zk(d), Zkg ),

– odporność na zużycie erozyjne ( Ze(d), Zeg ),

– żarowytrzymalość ( R’zT/t(d), R’zT/tg ),

– odporność na pękanie ( Kcd, Kcg ),

– cechy uzupełniające ( Cuid, Cuig ), ( i = 1,…, n )

Przedstawiony podzbiór tworzy podobszar zdatności Wu Ì Www przedstawiony wektorem:

Wu = [ Tss, TZ, TZk, TZe, TRz/T/t, TKc, TCui ] (91)

(92)

Ważnym, mało docenianym podzbiorem cech jest podzbiór charakteryzujący właściwości zamontowanego elementu w zespole czy całym systemie. Mogą to być:

– cechy sprawnościowe (wydajnościowe) systemu -ustalone podzbiorami Dwk i Sww elementu (CMSid, CMSig ), ( i = 1,…, n ),

– cechy związane z wyrównoważeniem elementów

(CMWjd, CMWjg ), ( j = 1,…, m ),

– cechy rozrzutu częstotliwości własnej kompletu elementów w systemie

(CMFld CMflg ), ( l = 1,…,L ),

– cechy zapewniające niski poziom głośności ( CMGkd, CMGkg ), ( k = 1,…, K ),

– cechy uzupełniające (CMXod, CMXog ), ( o = l,…, O ).

Zbiór wymienionych cech tworzy podobszar zdatności WMe Ì Wz o postaci:

WMe = [ TCMSi, TCMWj, TCMFl, TCMGk, TCMXo ] (93)

i macierz:

(94)

Jak już wspomniano wcześniej, to każda cecha, oprócz nazwy, powinna zawierać wartość liczbową (tolerancję lub wartości graniczne) lub charakterystykę opisową. Można też przyporządkować Jej dodatkowe oznaczenia identyfikacyjne, np. numer podzespołu, zespołu systemu lub numer montażowy. Powinny też być podawane informacje o sposobie wyznaczania wartości liczbowych (wykresy, normatywy, wzory matematyczne) i o rodzaju dokumentacji, gdzie cecha powinna być zapisana.

Analiza cech obszaru Wz (elementów macierzy AWz ) powinna być wspomagana opracowywanymi zależnościami pomiędzy warunkami (parametrami), wariantami procesu technologicznego, oddziaływaniami czynników wymuszających wj(t) i cechami yij czy nawet podzbiorami zdatności w postaci:

yij = f (Xl); ( l = 1, 2,…, L ) (95)

gdzie: i – liczba kolumn macierzy ( i = l, 2,…, 21 ),

j – liczba wierszy macierzy ( j = l, 2,…, 6 ),

lub też w postaci:

Wzr = f (Xl); ( r = 1, 2,…, 6 ). (96)

Mogą być również badane zależności (jako relacje wewnętrzne) pomiędzy poszczególnymi elementami macierzy AWz:

bez zajścia s = p (97)

Związki określające relacje (95-96) można opracowywać w formie modeli matematycznych, wzorców struktury materiału rdzenia, charakterystyk podstawowych WW, nomogramów, wykresów, instrukcji technologicznych, wzbogacając materiał źródłowy do ustalenia obszaru zdatności Wz w zależności od przyjętego poziomu niezawodności R(0) który jest utrzymany w przypadku:

R(0) = P ( yij Î Wz ) (98)

Jeżeli wszystkie elementy yij macierzy AWz zawierają się w obszarze Wz to można też przyjąć, że niezawodność R(0) = 1.

W czasie eksploatacji obiektu, na skutek oddziaływania czynników wymuszających wj(t), ulegają zmianie w sposób losowy cechy yij obszaru zdatności Wz elementu ukształtowane w procesie wytwarzania. Każda cecha jest odpowiednim funkcjonałem o postaci:

yij(t) = f [ wj(t), yij, t ]. (99)

Zmianę zaś obszaru zdatności Wz(t) można traktować jako proces stochastyczny mogący być przedstawiony relacją:

Wz(t) = f [ wj(t), Wz, t ]. (100)

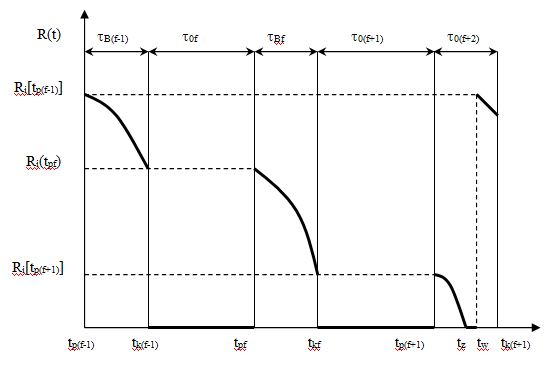

W rozważanym okresie eksploatacji elementu, np. w czasie równym zasobowi ustalonemu Zu, kształtowana funkcja niezawodności powinna spełniać warunek:

R(t) ³ R(t)dop., (101)

gdzie R(t)dop jest obliczonym i ustalonym poziomem niezawodności elementu. Odpowiada mu również ustalony obszar zdatności Wz(t)dop. i wynikające z tego ograniczenie dla każdej cechy obszaru, tj.

yij(t) ³ yij(t)dop. (102)

W związku z tym warunek utrzymania poziomu niezawodności R(t)dop. będzie następujący:

R(t)dop. = P [yij(t) Î Wz(t)dop. ]. (103)

Z przedstawionych relacji wynika, że racjonalne ustalanie cech obszaru zdatności Wz elementów i całych systemów technicznych wymaga istnienia w zakładowym (branżowym) systemie jakości dwóch zintegrowanych ze sobą podsystemów kształtowania niezawodności obiektów, tj. podsystemu konstrukcyjno-eksploatacyjnego i podsystemu technologicznego.

W całej działalności badawczo-konstrukcyjnej podsystemu pierwszego ważną rolę odgrywają badania związków określonych relacją (99) usiłujące w coraz większym stopniu uwzględniać rzeczywistą probabilistyczną naturę procesu [1]. W badaniach tych niezawodne są informacje o zmianach stanów technicznych systemów i elementów zachodzących w ich eksploatowaniu, których metody opracowywania podano w [16] i w innych licznych pracach prezentowanych na konferencjach i sympozjach naukowych. Pomimo tego w dalszym ciągu istnieje skąpy przepływ informacji ze sfery eksploatacji. Stąd też wydaje się uzasadnione tworzenie podsystemu łączącego sferę badawczo-projektową i sferę eksploatacyjną.

Podstawowa rola podsystemu technologicznego w ustalaniu obszaru zdatności Wz obiektów technicznych to opracowywanie metod i sposobów urzeczywistniania wcześniej proponowanych cech Wz, poprzez stymulowanie prac w trzech zasadniczych kierunkach, tj. [1, 2]:

- opracowywania nowych tworzyw konstrukcyjnych,

- opracowywania szczegółowych zależności zgodnie z relacjami głównie (95) i (96),

- prowadzenia całościowej działalności badawczej sterowania niezawodnością obiektów metodami technologicznymi.

Stąd też podzielona przez wielu autorów opinia, jakoby zadaniem sfery wytwarzania było tylko bierne odtwarzanie na obrabianych elementach zadanych przez projektantów cech Wz, wydaje się niewłaściwa.

Przedstawiony macierzowy zapis cech obszaru zdatności Wz należy traktować jako jedną z prób zwartego i przejrzystego zapisu warunków do ukształtowania niezawodności początkowej elementów i systemów technicznych stanowiących próbę uporządkowania dotychczas stosowanego, niespójnego opisu zbioru cech obszaru Wz.

Ujednolicony zapis obszaru Wz może ściślej zintegrować wszystkie sfery związane z powstawaniem i istnieniem obiektów (zgodnie z pętlą jakości – rys. 7) w zakresie opracowywania racjonalnych metod sterowania ich niezawodnością, z wykorzystaniem techniki komputerowej, budowaniem bazy badawczej i banków doradczo-informacyjnych (systemów ekspertowych) [13].