4.3.1. Punkty dostępowe

Podstawowym elementem sieci bezprzewodowej są punkty dostępowe. Wybierając określony model punktu dostępu, należy rozważyć wiele czynników.

♦ Zgodność urządzenia ze standardem 802.11.

♦ Możliwość zastosowania anteny zewnętrznej użytecznych w tworzeniu obszarów o gęstym pokryciu. Nie wszystkie punkty dostępu wyposażone są w możliwość podłączenia anteny zewnętrznej.

♦ Zapewnienie bezpieczeństwa przekazu danych – możliwość łatwego uaktualnienia do struktur bezpieczeństwa tworzonych obecnie przez grupę 802.11i.

♦ Roaming między punktami dostępu – wybór produktów od jednego dostawcy.

Brak standardu powoduje, że nie ma gwarancji, iż punkty dostępu różnych dostawców będą współpracować ze sobą.

♦ Posiadanie funkcji oszczędzania energii, zapewnia dłuższą pracę na bateriach.

♦ Zasilanie punktu dostępowego.

♦ Zarządzanie urządzeniami.

♦ Zasięg działania punktów dostępowych.

♦ Współpraca z różnymi kartami bezprzewodowymi.

♦ Moc przetwarzania punktu dostępowego – czy jest wystarczająca do działania z maksymalną wydajnością sieci WLAN przy włączonym protokole WEP?

Wszystkie te czynniki są bardzo ważne i zanim zdecydujemy się na konkretny AP należy sprawdzić jego wszystkie parametry, a co za tym idzie sprawdzić czy będzie on odpowiednim urządzeniem dla naszych warunków środowiskowych.

4.3.2. Rodzaje anten

Ponieważ anteny stosowane w kartach sieciowych i punktach dostępowych, są przystosowane do działania na ograniczonym obszarze, dlatego w celu właściwego pokrycia powierzchni często należy zastosować anteny zewnętrzne. Wybierając taką antenę należy zwrócić uwagę na kilka opisujących ją parametrów.

Zysk anteny – „stopień, w jakim sygnał jest wzmacniany na kierunku maksymalnego promieniowania przez antenę.” Jednostką zysku anteny jest dBi, który mówi o ile decybeli poziom sygnału z danej anteny jest większy w porównaniu z anteną izotropową[1](dla przykładu antena 8dBi nadaje sygnał o 6,31 razy silniejszy w stosunku do anteny izotropowej). Średnia wartość zysku prostych anten waha się w przedziale 3a7 dBi.

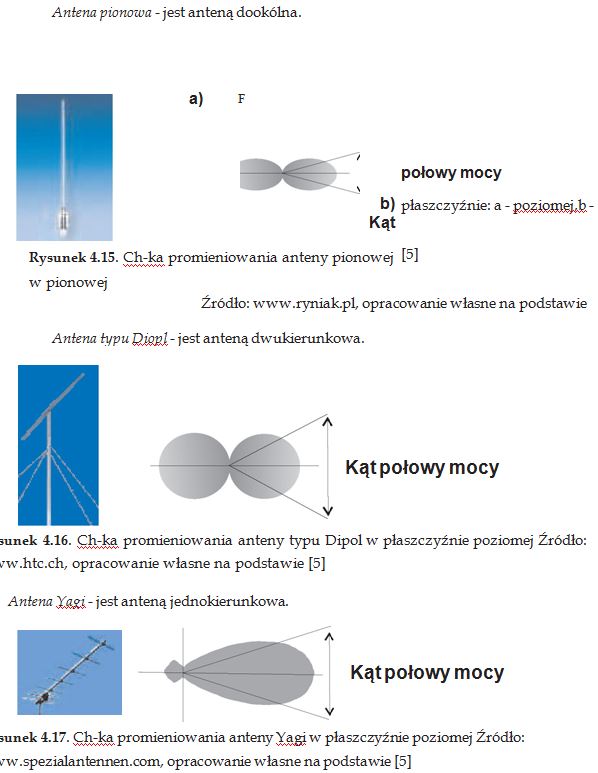

Kąt połowy mocy – parametr ten mówi nam o szerokości wiązki promieniowania. Jest on mierzony pomiędzy punktami, w których promieniowanie maleje do połowy swojej wartości szczytowej. Parametr ten odgrywa ważną role w efektywnym pokryciu powierzchni przy użyciu konkretnej anteny.

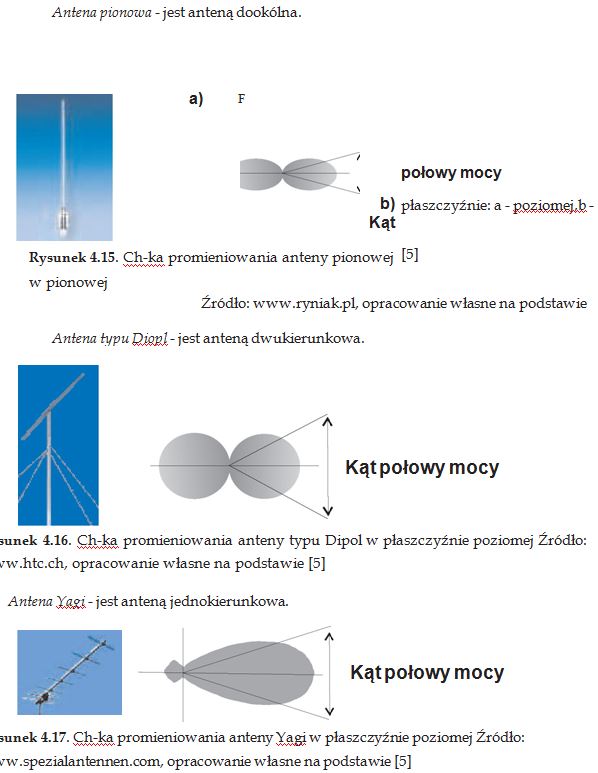

Rodzaj anteny – określa charakterystykę promieniowania danej anteny. Wyróżniamy trzy rodzaje charakterystyk promieniowania:

- dookólną, anteny z taka charakterystyką stosuje się, gdy trzeba pokryć duży obszar;

- dwukierunkową, anteny z taka charakterystyką stosuje się, gdy powierzchnią pokrycia jest np. korytarz;

- jednokierunkową, anteny z taka charakterystyką stosuje się, gdy budujemy połączenie typu punkt-punkt.

Rodzaje anten zostały przedstawione na stronie 25, teraz zajmę się tylko charakterystykami promieniowania tych anten. Charakterystyki te są bardzo pomocne w trakcie wybierania rodzaju anteny jaką należy zastosować [5].

4.3.2. Kanały radiowe

Urządzenia WLAN 802.11b/g pracują w paśmie częstotliwościowym w zakresie 2,412^2,472 GHz (jest to nielicencjonowane pasmo i dlatego tylko nim się zajmę), co stanowi 13 kanałów transmisyjnych, przedstawia to Tabela 4.3. Szczególnym kanałem jest kanał 10, który to jest dozwolony przez wszystkie władze regulacyjne i w większości AP jest domyślnie wybierany przy pierwszym włączeniu urządzenia.

Tabela 4.3. Kanały radiowe w domenie regulacyjnej ETSI

|

Numer kanału

|

Częstotliwość kanału [GHz]

|

|

1

|

2,412

|

|

2

|

2,417

|

|

3

|

2,422

|

|

4

|

2,427

|

|

5

|

2,432

|

|

6

|

2,437

|

|

7

|

2,442

|

|

8

|

2,447

|

|

9

|

2,452

|

|

10*

|

2,457

|

|

11

|

2,462

|

|

12

|

2,467

|

|

13

|

2,472

|

Źródło: Opracowanie własne na podstawie [5]

Sieć WLAN ma architekturę komórkową, gdzie każdą komórkę tworzy pojedynczy AP (pracuje on w jednym kanale radiowym). Jeżeli sieć zostanie źle zaprojektowana mogą pojawiać się harmoniczne od sąsiednich AP, co spowoduje ich interferencję. Ponieważ dla każdego kanału radiowego moc drugiej harmonicznej maleje o połowę w porównaniu do mocy pierwszej harmonicznej, natomiast moc trzeciej harmonicznej maleje o połowę w porównaniu do mocy drugiej harmonicznej, itd., kanały radiowe dla sąsiadujących punktów dostępowych w 802,11b/g muszą być oddalone od siebie o 5 kanałów, jak widać na Rysunku 4.19.

4.3.2. Obliczenia

1. Obliczenie liczby potrzebnych punktów dostępowych

Ponieważ WLAN ma budowę komórkową do obliczenia liczby potrzebnych AP, można wykorzystać metodę jaką używa się w telefonii komórkowej.

Pierwszym krokiem w tej metodzie jest obliczenie całkowitej powierzchni pokrycia, przy czy należy uwzględnić promień komórki, który wynosi R=17m (komórka taka swoim zasięgiem obejmie dwie kondygnacje). Przy 3-piętrowym budynku zazwyczaj wystarczy policzyć powierzchnię 2 kondygnacji, wyjątek mogą stanowić budynki w których stropy są zbrojone (bardzo duże tłumienie sygnału). Całkowita powierzchnia pokrycia dla budynku o wymiarach 35×70 m parter i I piętro, a 21×70 m pozostałe dwa wynosi:

NC = 35m-70m + 21m-70m = 2450m2 + 1470m2= 3920m2

Jeśli przyjmiemy, że średnio kanał jest zajmowany przez użytkownika przez 20 minut (w przedziale 0^100 minut), wówczas ruch powodowany przez takiego użytkownika będzie wynosił 0,2 Erlanga.

Następnym krokiem jest obliczenie powierzchni jaką obejmuje pojedyncza komórka:

(Pole)R = |-/2-i?2 = 2, 5981- 1T2 = 750,85?b2

Znając całkowitą powierzchnię pokrycia oraz powierzchnię jaką obejmuje AP, możemy obliczyć ilość punktów dostępowych potrzebnych do pokrycia całego budynku:

Obliczenia te są teoretyczne i odnoszą się do 100% użycia punktów dostępowych. Jednak w praktyce wykorzystanie AP jest znacznie mniejsze, dlatego też można zastosować mniejszą ich liczbę. W przedstawionym powyżej budynku wystarczą 4 AP po dwa na parterze oraz na 2 piętrze dla zapewnienia całkowitego pokrycia [14].

2. Obliczenie zasięgu sieci

Obliczenia zasięgu są czysto teoretyczne i znacznie odbiegają od rzeczywistych wartości. Jednakże pozwalają określić przybliżoną wartość zasięgu danego urządzenia, a co za tym idzie wielokrotnie obniżyć koszt realizacji sieci.

Pierwszym krokiem jest obliczenie straty sygnału jaka występuję między urządzeniem nadawczym, a odbiorczym.

Dla pasma 2,4 GHz, czyli dla najczęściej stosowanego wartość tą wyliczamy ze wzoru:

L = 20 log (d) + 20 log (f) + 36,6

gdzie:

L – tłumienie [dBi];

d – droga, pomiędzy urządzeniem nadawczym, a odbiorczym [km]; f – częstotliwość [MHz].

W przypadku połączeni na odległość 5 km, przy zastosowaniu 6 kanału – 2,437 GHz (wybór kanału opisany jest w Rozdziale 4.3.3) straty wynoszą:

L = 20 log (5) + 20 log (2437) + 36, 6

L = 20-0, 69 + 20-3, 38 + 36, 6

L = 118

Strata na łączu 5 km wynosi 118 dBi.

W kolejnym kroku należy wziąć pod uwagę wszystkie elementy wzmacniające sygnał (takie jak urządzenie nadawcze, antenę, wzmacniacze, które należy dodać) oraz powodujące stratę (takie jak złączki, połączenia przewodowe, które należy odjąć).

Typowy układ nadawczo-odbiorczy składa się z:

nadajnika/ odbiornika,

- 2 pigtail’i,

- 2 złączy,

- kabla,

- anteny nadawczej/odbiorczej.

Jeśli w łączu zostanie użyty nadajnik o wzmocnieniu 15 dBi oraz anteny, których wzmocnienie wynosi 12 dBi dla anteny nadawczej i 15 dBi dla anteny odbiorczej. Tłumienność pojedynczej złączki wynosi 0,25 dB, pigtail’i 1 dB, natomiast tłumienność kabla 0,22 dB/m. Wzmocnienie wyniesie:

Nadajnik : 15 – 2-1 – 2-0, 25 – 0, 22 + 12 = 24, 28[dB]

Odbiornik : 15 – 2-1 – 2-0, 25 – 0, 22 + 15 = 27, 28[dB]

Całkowite wzmocnienie: Nadajnik + Odbiornik = 51, 56[dB]

Od otrzymanego wzmocnienia należy odjąć straty sygnału jakie występują między urządzeniem nadawczym, a odbiorczym:

51, 56 – 118 = -66, 44[dB]

Wartość ta mówi nam o mocy sygnału na końcach łącza.

W ostatnim kroku należy porównać otrzymany wynik z czułością zastosowanego urządzenia nadawczego oraz odbiorczego. Dla wartości przedstawionych w Tabeli 4.4, przy przepływności 11 Mb/s czułość AP wynosi -83 dB, od której to należy odjąć otrzymaną moc sygnału:

83 – 66, 44 = 16, 56[dB]

Teoretycznie jest to wartość pozwalająca na poprawną transmisję z prędkością 11 Mb/s, w praktyce jednak margines dopuszczalnego błędu szacowany jest na 20 dB (zapewnia to stabilną transmisję niezależnie od warunków atmosferycznych) [9].

Tabela 4.4. Czułość punktu dostępowego

|

11 Mb/s

|

5 Mb/s

|

2 Mb/s

|

1Mb/s

|

|

-83 dB

|

-87 dB

|

-90 dB

|

-92 dB

|

Źródło: Opracowanie własne na podstawie [9]

Rozdział czwarty opisuje sposób projektowania sieci komputerowych LAN i WLAN. Zawiera informacje odnośnie: wyboru medium transmisyjnego, topologi fizycznej, topologii logicznej; a w przypadku sieci bezprzewodowych, także o wyborze: AP, kanałów radiowych oraz anten. W rozdziale tym opisałam sposób obliczania ilości potrzebnych punktów dostępowych oraz zasięgu sieci.

[1] Antena izotropowa jest to antena, która we wszystkich kierunkach równomiernie wysyła sygnał. Sygnał jaki dociera do anteny jest transmitowany w powietrze bez odbić, strat. Zysk takiej anteny wynosi 0 dBi.