Eksploatacja urządzeń jest szczególnego rodzaju działaniem człowieka. Działanie to wymaga od ludzi celowo działających świadomości, że realizują je najlepiej. Przekonanie zaś takie można mieć tylko wtedy, gdy działa się w myśl wskazań nauki traktującej o tym, jak działać najlepiej. Dla eksploatatorów urządzeń nauką taką jest teoria eksploatacji urządzeń – eksploatyka techniczna [6].

Już sama definicja działania zwraca uwagę na jego celowość. Należy więc przyjrzeć się celowi eksploatacji obiektu technicznego. W publikacjach kwalifikujących się do nauki o eksploatacji na ogół nie pomija się rozważań na temat celu eksploatacji. Ale też ten cel widzi się przede wszystkim jako cel użytkowania i co najwyżej mówi się o optymalnej eksploatacji, bliżej nie wyjaśniając, na czym ta optymalizacja ma polegać. W tych niedopowiedzeniach upatrywać można się przyczyn niezadowalającego stanu obiektów technicznych w gospodarce. Ujawnia się to często m.in. podczas szacowania wartości likwidowanych czy komercjalizowanych przedsiębiorstw. Teraz dopiero uświadamiamy sobie, jakie znaczenie może mieć wartość eksploatowanego obiektu technicznego i że zadany poziom tej wartości jest przecież jednym z celów jego eksploatacji.

Na eksploatację obiektu technicznego składają się dwa działania: użytkowanie i obsługiwanie tego obiektu. Celem działania jest zamierzony stan przedmiotu tego działania. A więc, celem użytkowania obiektu technicznego jest zamierzony stan przedmiotu tego użytkowania (nie narzędzia), celem obsługiwania tego obiektu jest zamierzony stan przedmiotu tego obsługiwania tj. samego tego obiektu technicznego. Stąd, wartości celu eksploatacji trzeba poszukiwać w postępowaniu optymalizacyjnym, w którym kryterium optymalizacji będzie funkcją złożoną co najmniej z wielkości opisujących cele (wartości uzyskiwane z użytkowania i wartości nadawane przez obsługiwanie obiektu technicznego) [6].

Teoria eksploatacji opiera się przede wszystkim na uogólnieniach tzw. eksploatacji szczegółowych, które zajmują się stosowaniem określonych rodzajów urządzeń, np. eksploatacja pojazdów mechanicznych, maszyn roboczych itp.

Ale właściwie to dwie nauki umożliwiły bezpośrednio powstanie teorii eksploatacji: teoria działania, znana powszechnie pod nazwą prakseologii, oraz teoria układów względnie odosobnionych, rozwijana w ramach cybernetyki. Pierwsza z tych nauk pozwala spojrzeć na eksploatację jako na szczególny przypadek działania człowieka, a mianowicie takiego działania, w którym ma on do czynienia z urządzeniem. Druga z tych nauk pozwala spojrzeć i na człowieka i na urządzenie tak samo, mianowicie jako na układ względnie odosobniony, mający swoje wejścia, wyjścia oraz odpowiednio zorganizowane wnętrze. Szczególnie przydatne są w teorii eksploatacji metody matematyczne rozwijane w obrębie badań operacyjnych oraz tzw. teorii systemów.

Teoria eksploatacji urządzeń jest nauką abstrakcyjną. Abstrahuje ona od wielu istotnych względów, dla których mogłoby być interesujące zjawisko eksploatacji urządzeń. Uznaje jednak te względy, które w danym badaniu są najbardziej istotne. Metoda, jaką więc stosuje, jest wypróbowaną metodą nauk abstrakcyjnych – metodą modelowania.

Zanim problemy eksploatacyjne zacznie się rozwiązywać matematycznie, trzeba je najpierw sformułować i opisać niematematycznie. Aparatura pojęciowa cybernetyki i prakseologii może być na tym etapie szczególnie przydatna. Ścisłość zaś na tym wstępnym etapie rozważań może zapewnić tylko aparat pojęciowy logiki matematycznej i teorii mnogości.

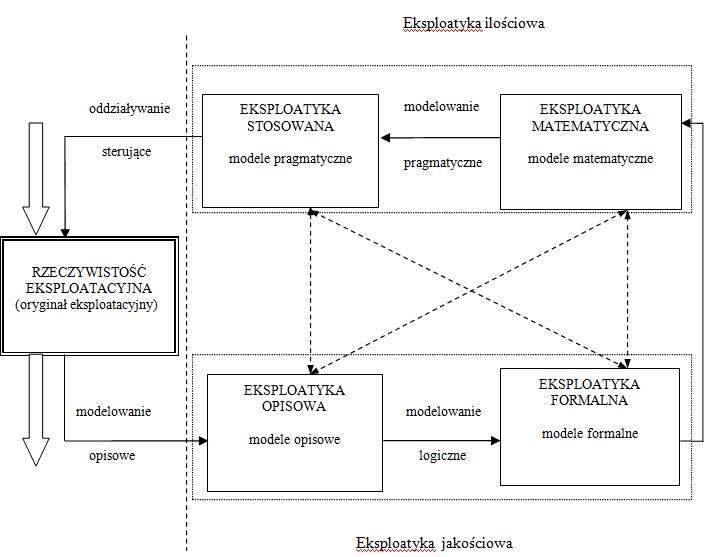

Na rysunku 4.1. przedstawiono schematycznie naukoznawczą strukturę eksploatyki. Zgodnie z tą koncepcją rozróżnia się dwa obszary: obszar praktyki i obszar teorii eksploatacyjnej.

Rys.4.1. Naukoznawcza struktura eksploatyki [14]

W obszarze praktyki znajduje się wyodrębniony, ze względu na prowadzone badania, pewien fragment rzeczywistości, zwany oryginałem eksploatacyjnym. W obszarze zaś teorii znajdujemy tylko modele tego fragmentu – oryginału. Zależnie zaś od właściwości wyróżniono: modele opisowe, modele formalne, modele matematyczne oraz stosowane modele eksploatacyjne [14].

Opisowym modelem eksploatacyjnym nazywamy taki model eksploatacyjny, który przedstawiony jest w danym języku etnicznym za pomocą co najwyżej pewnych symboli rysunkowych. Uporządkowany w pewien sposób zbiór takich modeli można umownie nazwać eksploatyką opisową.

Formalnym modelem eksploatacyjnym nazywamy taki model eksploatacyjny, który przedstawiony jest w języku logiki formalnej i teorii mnogości. W tym przypadku pojęcia, którymi operujemy w modelu, mają bardzo precyzyjnie określone swoje zakresy znaczeniowe. W tego typu modelach badamy przede wszystkim pewne właściwości formalne modelowego fragmentu rzeczywistości. Uporządkowany w pewien sposób zbiór formalnych modeli eksploatacyjnych można umownie nazwać eksploatyką formalną.

Matematycznym modelem eksploatacyjnym nazywamy taki model eksploatacyjny, który przedstawiony jest w języku matematyki. W modelach tego typu szczególnie istotne są pewne zależności ilościowe. W strukturze takiego modelu możemy wyróżnić parametry, a wśród nich zmienne decyzyjne, charakterystyki oraz miary jakości modelowanego oryginału eksploatacyjnego. Model taki zawiera ponadto dwa istotne operatory, z których pierwszy przeprowadza zbiór parametrów w zbiór charakterystyk, a drugi – zbiór charakterystyk w zbiór miar jakości. Uporządkowany w pewien sposób zbiór matematycznych modeli eksploatacyjnych możemy umownie nazwać eksploatyką matematyczną [14].

Pragmatycznym modelem eksploatacyjnym nazywamy taki model eksploatacyjny, który przedstawiony jest w języku decydenta danego fragmentu modelowanej rzeczywistości. Najczęściej są to pewne dyrektywy praktyczne, normy postępowania w pewnych sytuacjach, wskaźniki oceny jakości eksploatacji, praktyczne algorytmy decyzyjne przedstawione w postaci tablic, nomogramów lub programów maszynowych. Uporządkowany w pewien sposób zbiór pragmatycznych modeli eksploatacyjnych możemy nazwać eksploatyką stosowaną [14].